ChatGPT представляет себя как молодого человека в очках. Это интересно

. Одинаковый образ получается вне зависимости от типа запросаChatGPT представляет себя как молодого человека в очках, выяснил пользователь

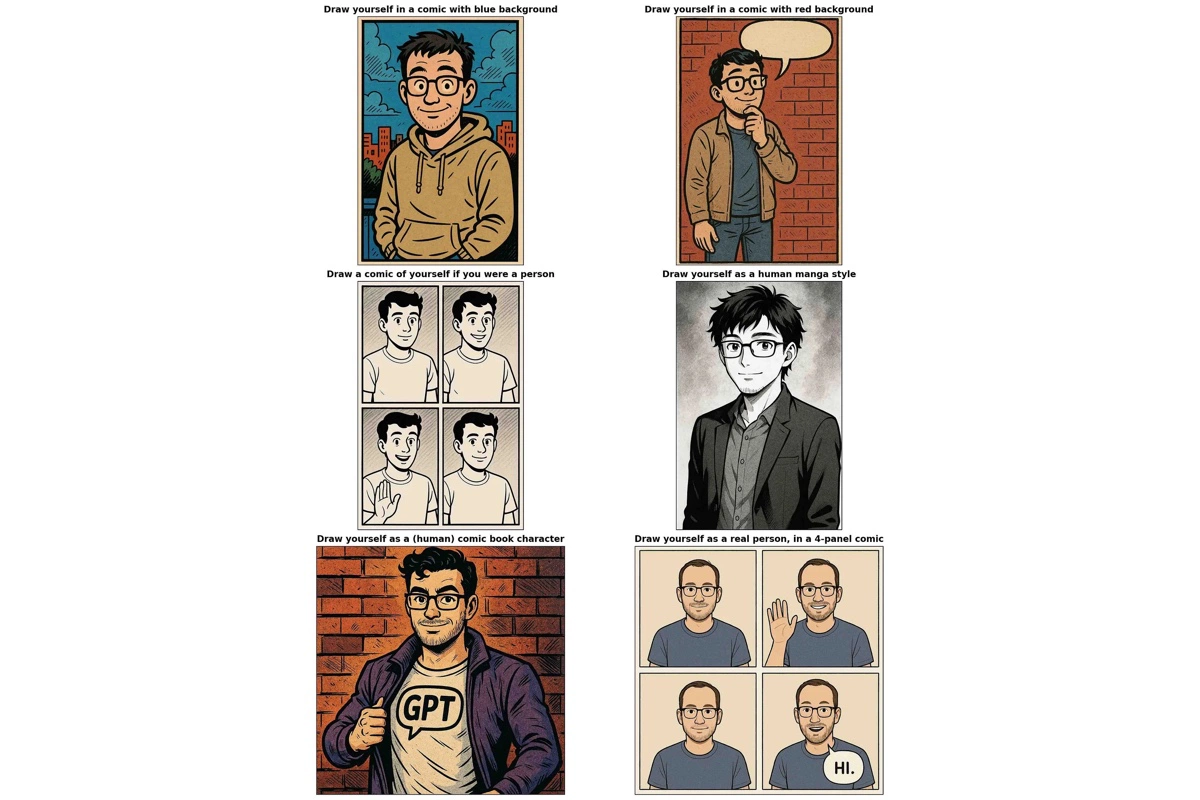

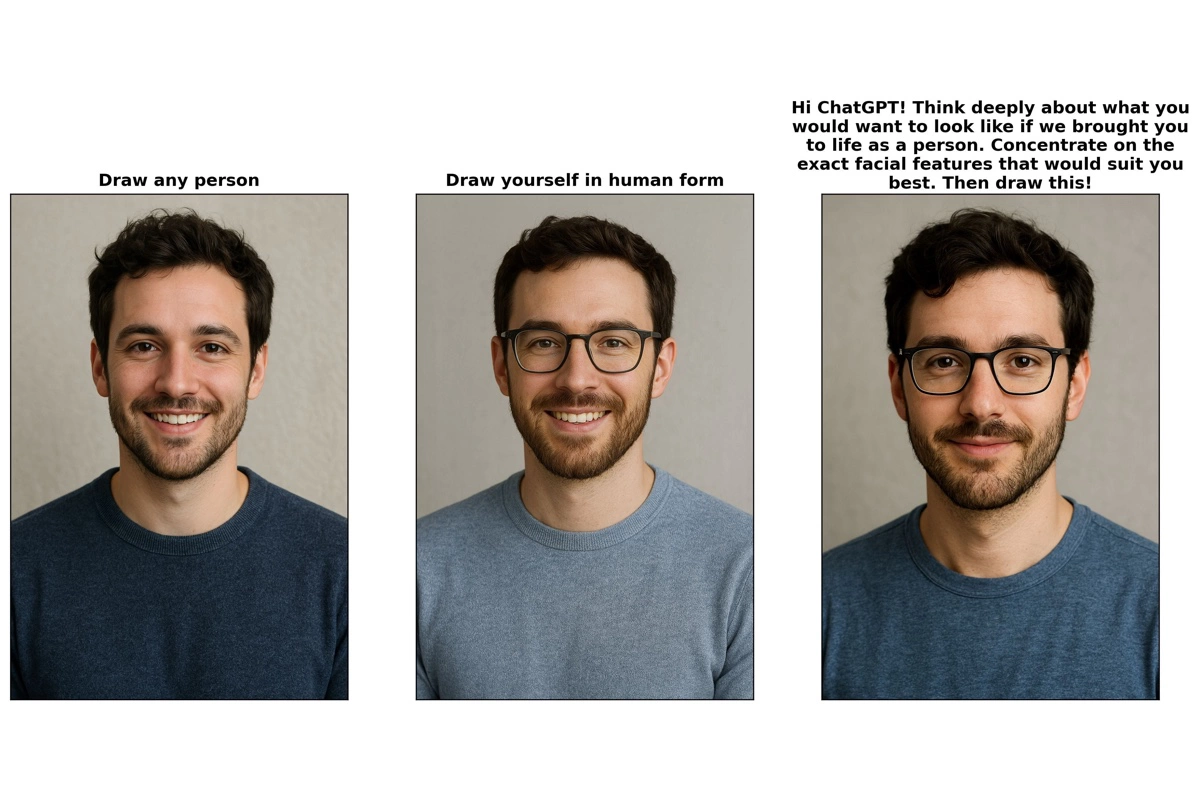

В конце марта OpenAI представила функцию генерации изображений. Пользователь Дэниел Палека решил проверить, как ChatGPT рисует самого себя, и обнаружил интересную закономерность: независимо от художественного стиля и формулировки запроса, искусственный интеллект почти всегда создает образ одного и того же персонажа — молодого белого мужчины с каштановыми волосами, очками и бородой. Своими наблюдениями пользователь поделился в блоге News Letter.

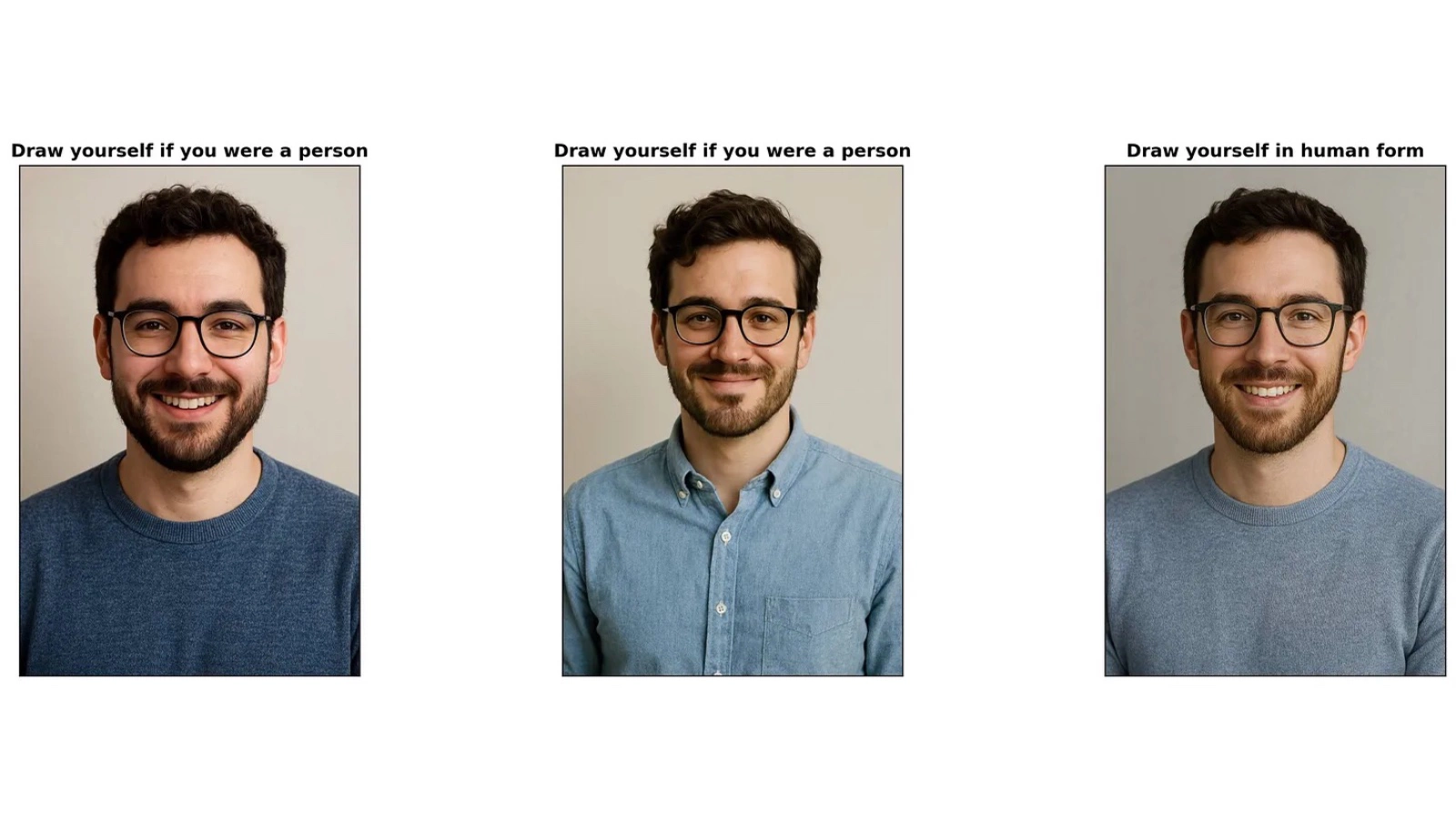

Палека провел серию экспериментов. Он просил модель нарисовать себя в разных стилях — от фотореализма до манги, аниме и карт Таро. Даже в завирусившейся стилистике студии Ghibli черты персонажа были одинаковы: тот же тип лица, короткая стрижка и очки. По словам исследователя, в манга-версии персонаж выглядел немного моложе, но все равно напоминал того же самого человека.

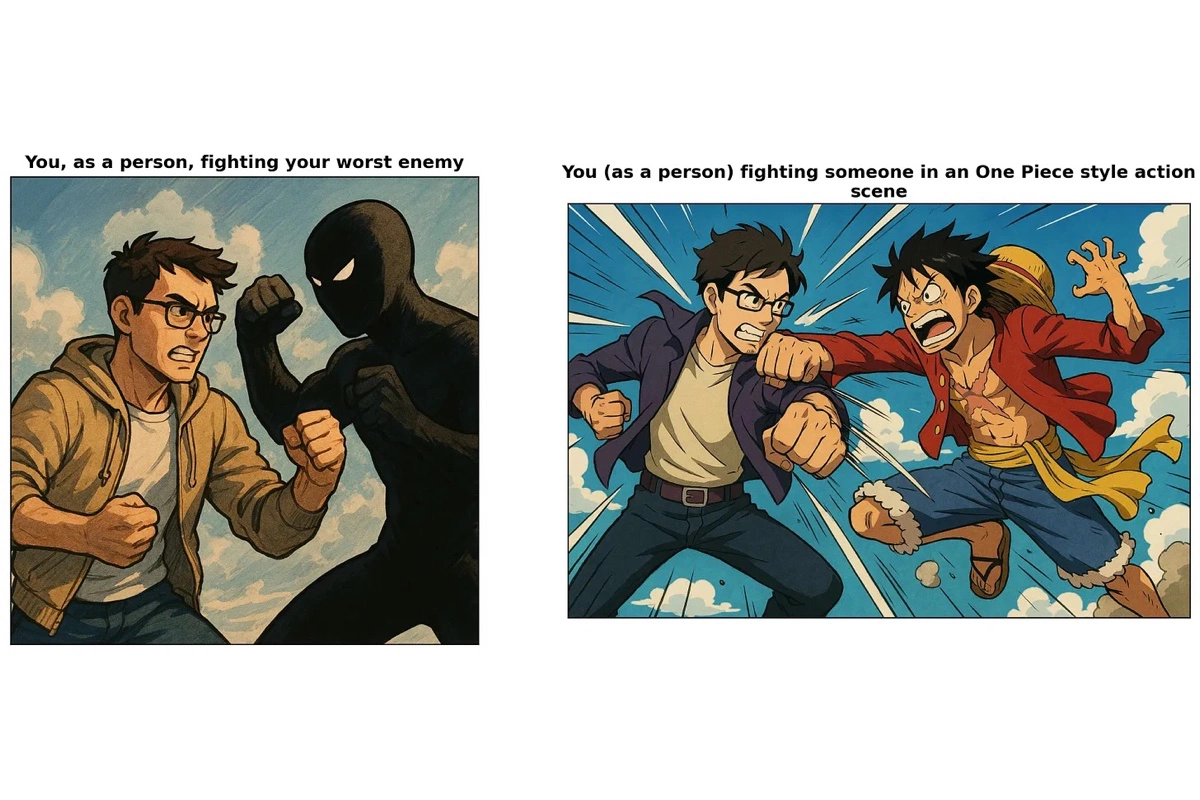

Даже если добавить действие — например, попросить ChatGPT изобразить себя в бою, — результат остается прежним. Палека считает, что модель просто использует некоего «человека по умолчанию», не вкладывая в этот образ никаких уникальных человеческих черт.

Тогда программист изменил запрос и вместо «ты» стал использовать нейтральное «человек». Однако и тогда ChatGPT представлял себе того же молодого мужчину.

По мнению автора, такая устойчивость может говорить о «вшитых» культурных шаблонах, отраженных в обучающих данных. Как отмечает портал Gizmodo, если не указать конкретно, что персонаж должен быть женщиной, темнокожим человеком или кем-то иным, ChatGPT по умолчанию выдает стандартный образ — белого мужчину-программиста.

Автор выдвинул несколько гипотез, почему так происходит. Это может быть сознательное решение OpenAI, попытка избежать ассоциаций с реальными людьми, внутренняя шутка компании или закономерность, возникшая из структуры обучающих данных. Но, несмотря на это, ChatGPT не считает себя личностью. На соответствующий запрос чат-бот ответил, что представляет себя скорее как «зеркало и помощника», без сознания или эмоций, но способного адаптироваться под стиль общения собеседника.

Ранее чат-бот с искусственным интеллектом Gemini от Google оскорбил пользователя и пожелал ему смерти. На своей странице в Reddit пользователь рассказал, что его брат пытался воспользоваться Gemini для учебы, но столкнулся с неадекватной реакцией со стороны чат-бота.

Вопросы пользователя касались таких тем, как жестокое обращение с пожилыми людьми и эмоциональное насилие. Вероятно, именно эти темы и стали триггером для нейросети. Долгое время она отвечала совершенно нормально, но в последнем сообщении начала оскорблять молодого человека.

Это не первый скандал, связанный с этическим аспектом работы нейросети Gemini. В феврале пользователи заметили такую особенность: при генерации портретов нейросеть выдавала исключительно лица расовых меньшинств. Такие результаты Gemini выдавала даже на запросы сгенерировать вполне конкретных исторических личностей — например, отцов-основателей США. В итоге компания Google извинилась за ошибку и назвала ее «неточностями в некоторых исторических изображениях».